YOLOv4

@AikenHong 20200726

基于YOLO v4 掌握一些CV方面训练的Trick,同时针对Typora的使用进行一个熟悉掌握。GITHUB CODE

一些相关的参考资料

⚡️https://zhuanlan.zhihu.com/p/150127712

⚡️https://www.zhihu.com/question/390191723/answer/1177584901

本文中一些其他的收获

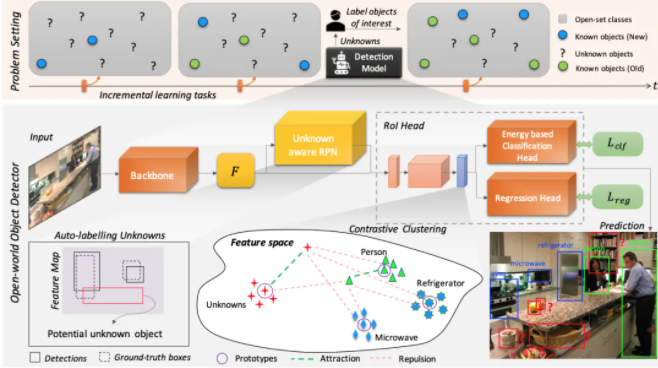

• 其他可替代的Object Detection的SOTA算法有哪些

• BoS,BoF方法

• 简直是一个Tricks的综述

Abstract

本文对近期再CNN上的一些Feature方法进行了尝试组合,并实现了新的SOTA,其实就是一些通用的**Trick**的组合尝试,包括

• 加权残差连接(WRC)

• Cross-Stage-Partial-connection,CSP

• Cross mini-Batch Normalization,CmBN